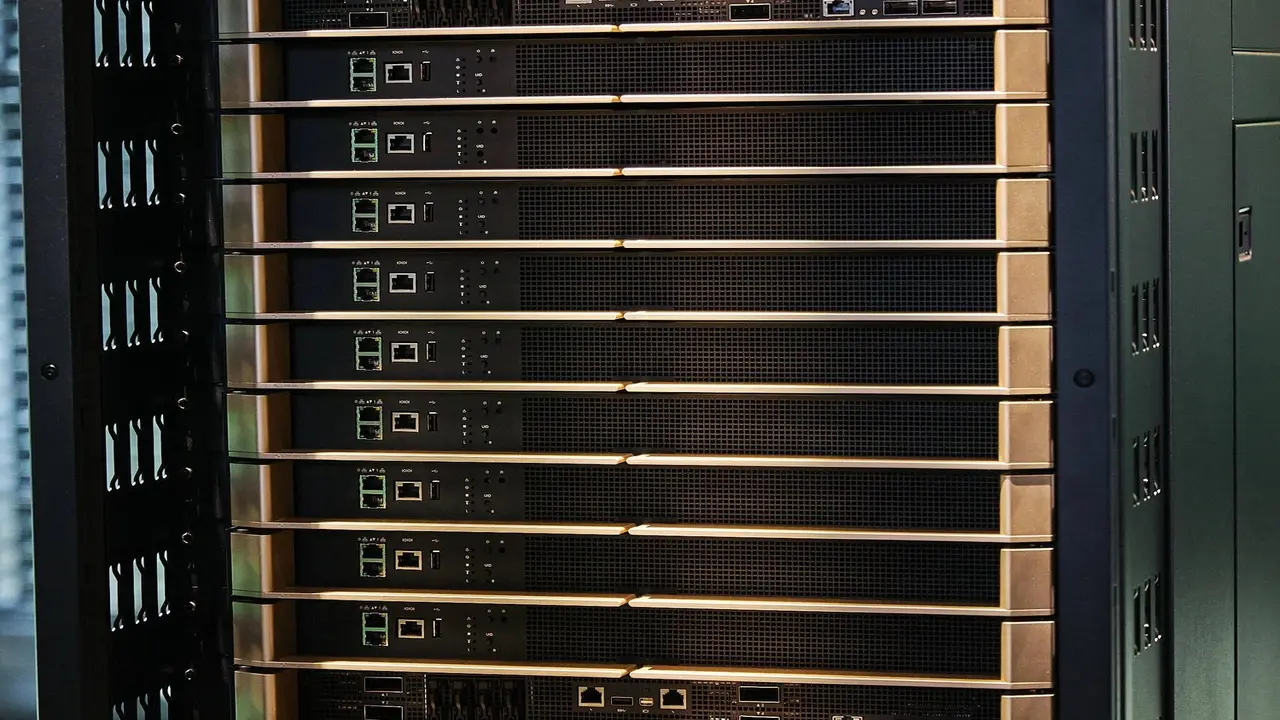

Nvidia, yapay zeka modellerinin gerçek zamanlı belleğini kökten dönüştürebilecek yeni bir paralel işleme yöntemi duyurdu. “Helix Parallelism” adı verilen bu teknik, özellikle büyük dil modellerinin milyonlarca kelimelik uzun içerikleri çok daha verimli ve gecikmesiz işlemesini sağlıyor. Geliştirme süreci, Nvidia’nın en yeni GPU mimarisi Blackwell üzerine inşa edildi.

Yapay zekada verimlilik artıyor

Yapay zeka modellerinin karşılaştığı en temel zorluklardan biri, geçmiş bilgileri hatırlayarak yeni içerik üretmeye devam edebilme kapasitesi diyebiliriz. Özellikle hukuk, tıp ya da müşteri destek sistemleri gibi uzun süreli geçmişe dayanan bilgiye ihtiyaç duyan uygulamalarda, bu geçmişin her kelime üretiminde yeniden taranması zorunlu hale geliyor.

Ancak bu işlem, GPU belleği üzerindeki yükü katlanarak artırıyor. Yapay zekâ modelleri, her yeni kelime için hem KV önbelleğine (Key-Value cache) hem de büyük boyutlu Feed-Forward Network (FFN) ağırlıklarına yeniden erişmek zorunda kalıyor. Bu da sistem kaynaklarını hızla tüketiyor ve işlemlerde gecikmeye neden oluyor.

Nvidia, Helix Parallelism ile bu iki darboğaza doğrudan müdahale ediyor. Yöntem, bir modelin dikkat (attention) ve FFN katmanlarını ayrı ayrı ele alıyor. Dikkat mekanizması için kullanılan KV Parallelism (KVP) tekniğiyle, geçmişe ait veriler farklı GPU’lar arasında bölüştürülüyor.

Böylece her GPU yalnızca kendi bölümünden sorumlu oluyor ve sistemin tüm geçmişi tekrar tekrar taramasına gerek kalmıyor. FFN katmanı ise klasik Tensor Parallelism (TP) ile çalıştırılıyor. Her iki süreç de paralel şekilde işliyor, böylece GPU’lar boşta beklemiyor.

Veri iletimi, Nvidia’nın yüksek hızlı iletişim altyapısı NVLink ve NVL72 üzerinden sağlanıyor. Ayrıca HOP-B adı verilen yeni bir yöntemle, hesaplama ve veri transferi işlemleri üst üste bindirilerek gecikme süresi minimuma indiriliyor. Bu sayede bilgi hem aktarılıyor hem de işleniyor; süreçler birbirini beklemiyor.

Simülasyon sonuçları, bu yeni yaklaşımın performansta büyük bir sıçrama sağladığını gösteriyor. DeepSeek-R1 671B isimli dev modelle yapılan testlerde, Helix yöntemi aynı gecikme süresiyle 32 kat daha fazla kullanıcıya hizmet verebildi. Düşük yoğunluklu kullanım senaryolarında ise tepki süresi 1.5 kata kadar kısaltıldı. Bu da hem yüksek performans hem de kaynak verimliliği anlamına geliyor.